2023-ban legalább 95 820 deepfake videót találtak az interneten.

Bár lehet, hogy szórakoztató és izgalmas nézni, ahogy Kendrick Lamar átváltozik Kanye West-é, Will Smith, pedig Nipsey-vé a Pulitzer-díjas rapper 2022-es The Heart Part 5 című számában, és talán még egy kis katartikus érzést is adhat, amikor újranézel egy jelentet Jon Snow-tól, aki bocsánatot kér a Trónok harca utolsó évadának cselekménye miatt.

Mi történik, amikor az MI manipuláció ilyen eseteit rosszindulatú célokra alkalmazzák? Az adatok és felmérések arra utalnak, hogy a legtöbb ember nem ismeri fel a deepfake-eket, és van, aki bevallja, hogy olyan videókat nézett meg, amelyeket kezdetben valósnak hitt, és csak később jött rá, hogy hamisak.

A legtöbb esetben a deepfake-ek jelentette veszélyekre irányuló figyelem általában a politikai dezinformációra összpontosít. Azonban ezt a technológiát következetesen használják nőkkel szembeni zaklatásra és visszaélésekre is. Erre egy példa Taylor Swift esete, aki a beleegyezése nélkül pornográf anyagok áldozatává vált.

„Sajnos nem kellene meglepődnünk azon, hogy a deepfake-eket nők degradálására használják” — mondta el Sophie Toupin, a Université Laval Információs és Kommunikációs Tanszékének adjunktusa a TRT Worldnek.

Miután január végén a közösségi médiában tűzszerűen elterjedtek az Anti-Hero énekesnőjéről készült szexuális deepfake-ek, Swift rajongótábora, a Swifties gyorsan akcióba léptek. A rajongók hamar elárasztották az X platformot pozitív képekkel Swift-ről, valamint jelentették azokat a fiókokat, amelyek megosztották a deepfake-eket, ezzel a #ProtectTaylorSwift a trendek közé került.

A Swifties válasza hatalmas társadalmi és kulturális jelentőséggel bír, mondta Toupin, mivel segít felállítani a normákat a mesterséges intelligencia (MI) által generált szintetikus média elfogadható és nem elfogadható használatáról — függetlenül attól, hogy valaki a világ egyik legnagyobb popsztárja, vagy sem.

„Bár ez a gyors válasz rendkívül sikeres volt, fontos kiemelni, hogy nem mindenki rendelkezik ilyen erős közösségi támogatással” — mondta Toupin. „Taylor Swift rajongói közössége figyelemre méltó példát szolgáltatott egy feminista válaszra, amely határozottan kijelentette: 'Ez nem elfogadható.'”

Remélem, hogy minden nő és lány, aki ilyen degradáló gyakorlatnak van kitéve, ugyanilyen gyors választ kap. Valójában közösségi szinten ennek a szolidaritásnak van szüksége ahhoz, hogy nemet mondjunk a nőgyűlölő és rasszista, MI által generált hamis tartalomra az interneten.

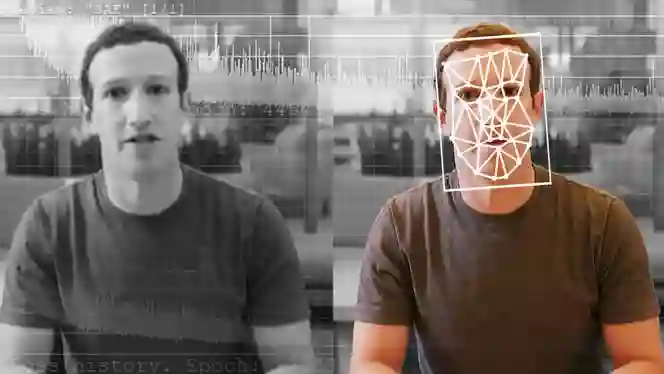

Egyszerűsítve, a deepfake-ek olyan szintetikus médiai formák, amelyek MI-t használnak egy személy hasonlóságának és arcképének kicserélésére egy másikéval videókban.

A technológia egy Reddit felhasználónak köszönhető, aki a „Deepfakes” néven vált ismertté, 2017-ben beleegyezés nélkül kezdett el olyan digitálisan módosított felnőtt tartalmakat gyártani, amelyekben hírességek arca volt ráhelyezve nők testére felnőtt filmekben.

A Vice Motherboard-nak nyilatkozva a felhasználó elmondta, több nyílt forráskódú könyvtárat használt a videók készítésére, köztük a Google TensorFlow-ját, amely ingyenesen elérhető.

„Technikai szempontból kulcsfontosságú figyelembe venni azt, hogy a legtöbb ember által létrehozott MI által generált deepfake-ek egyszerűsége az elérhető MI alapú szoftvereken múlik” — magyarázta Toupin — „Ezeket a szoftvereket hatalmas mennyiségű, az internet felhasználói által az elmúlt két évtizedben generált és megosztott tartalomra képezték ki. Ezt fontos figyelembe venni.”

Miután Taylor Swiftet deepfake támadások érték, törvényhozók és egyszerű állampolgárok követelték a mesterséges intelligencia által létrehozott képek elleni erősebb védelmet, amelyek világszerte, Ausztráliától Spanyolországig, riasztó gyorsasággal szaporodnak, miközben túlnyomórészt nők és gyermekek esnek áldozatul.

Nemrégiben Georgie Purcell, ausztrál parlamenti képviselő kifogásolta egy helyi hírmédia által készített módosítást, amelynek következtében a mellei nagyobbnak tűntek, és részben eltávolították a ruhájának egyes részeit, ami szerinte a politikai életben a nőkkel szembeni „folyamatos, alattomos” bánásmód példája.

Egy 2023-as jelentés szerint a deepfake pornográfia teszi ki a deepfake videók 98%-át az interneten, valamint a deepfake pornográfiában célba vett személyek 99%-a nő, mindezek egy megfelelőbb szabályozási keretrendszer szükségességét mutatják.

„Ne felejtsük el, hogy ha olyan szintetikus médiát fogyasztunk, amelyet az ábrázolt személy beleegyezése nélkül készítettek, akkor mi is a probléma részévé válunk” — mutatott rá Toupin. „Fontos, hogy megértsük, a nemi alapú digitális erőszakban lelünk örömöt.”

Bár forradalmi, a deepfake-ek kora új kihívásokat és félelmeket teremt a törvényhozók és kormányok számára, akik kétségbeesetten próbálják megfelelően szabályozni ezt a technológiát, amely képes bárkit úgy feltüntetni, hogy bármit mondjon és tegyen bármilyen pillanatban.

A dezinformáció és deepfake-ek egyre növekvő hozzáférése, ahogy azt a 2022-es Európai Unió Igazságügyi Együttműködési Ügynökség (Europol) jelentése is állítja, „mély hatást gyakorol majd arra, ahogyan az emberek az autoritásokat és az információs médiát érzékelik, miközben aláássa a hatóságokba és a hivatalos tényekbe vetett bizalmat.

„A szakértők attól tartanak, hogy ez olyan helyzethez vezethet, ahol az állampolgárok már nem osztoznak közös valóságban, vagy társadalmi zűrzavart okozhat abban, hogy mely információs források megbízhatóak; ezt a helyzetet néha 'információs apokalipszisnak' vagy a 'valóság apátiának' nevezik” — áll az Europol jelentésében.

Hosszú ideig az emberek fényképeket és videókat használtak annak kiegészítésére, amit olvastak, mielőtt teljes mértékben elfogadták volna az információt tényként; lényegében a „Ne hidd el, amíg nem látod” tanácsot követték.

Az aggodalmaik nem alaptalanok. Egy hamis robocall (számítógép által generált hangfelvétel) terjedt, amelyben Joe Biden elnök MI által generált hangja arra buzdította New Hampshire lakóit, hogy ne szavazzanak az állam demokratikus előválasztásán.

2023 szeptemberében Florida kormányzója, Ron DeSantis vált egy vírusos deepfake célpontjává, amely bejelentette, hogy kilép a 2024-es elnöki versenyből, miután néhány hónappal korábban egy MI-manipulált videót tett közzé, amelyben Donald Trump korábbi elnök és Anthony Fauci ölelkeztek.

„A szükséges eszközök és rendszerek könnyen elérhetők” — mondta Charles King, a Pund-IT technológiai ipari elemzője a Forbesnak. „Az Egyesült Államok jelenlegi politikai légköre olyan megosztott és csúnya, hogy mindkét oldalról nagy és kész közönségek vannak, akik hajlandóak elhinni a legrosszabbat másokkal kapcsolatban."

Az újságírásban és a nyomozói munkában az audio- és vizuális felvételek, fényképek és szövegek nemcsak megbízható bizonyítékként szolgálnak, hanem segítenek az újságíróknak, illetve nyomozóknak meghatározni, mi a valódi és mi nem.

Korábban is léteztek digitális manipulációs formák, mint például a Photoshop, de általában bizonyos szintű szakértelemre volt szükség ahhoz, hogy elrejtsük a szerkesztés nyomait. Ráadásul az eredmények általában nem voltak olyan kifinomultak, mint azok, amelyeket az MI technológia képes létrehozni.

Az MI jelenlétével a hamis információk lehetősége exponenciálisan nő, különösen konfliktusos és háborús időkben — mondta el Dr. Kalev Hannes Leetaru, a GDELT Projekt, a globális események, nyelv és hang adatbázisának alapítója.

„Jelenleg rengeteg lehetőség van a rosszindulatú szereplők számára — legyen szó Gázáról, Ukrajnáról vagy bármely más konfliktusról — ezeket az eszközöket arra használják, hogy személyre szabott, nagy léptékű hamis információkat hozzanak létre” — mondta el Leetaru, akinek munkája a technológiák kihasználására, valamint azok globális társadalomra gyakorolt hatásainak megértésére szakosodott.

„Képzelje el, hogy egy közösségi média platform vagy rosszindulatú szereplő az egész ország lakosságát figyeli, azután minden egyes személynek olyan tartalmat ad, amelyet a történelmük alapján tudják, hogy annyira fel fogja hergelni őket, hogy valóban szétrobbantja a társadalmat” — magyarázta — „Vagy fordítva, amikor a háborús bűnökről készült hiteles dokumentáció jelenik meg egy konfliktusövezetből.”

2022-ben egy hamis videó jelent meg, amelyben Volodimir Zelenszkij ukrán elnök azt mondta katonáinak, tegyék le a fegyvert Oroszország ellen, de sokan helyesen felismerték a digitális manipuláció jeleit, például azt, hogy az arca kissé nem volt szinkronban a fejével, és az akcentusa is furcsán hangzott.

A következő év júniusában több orosz média is beleesett egy hasonló, de meggyőzőbb hamisított videóba, amelyben Vlagyimir Putyin orosz elnök szerepelt.

Izrael háborúja Gázában növelte a félelmeket az MI félrevezető hatalmával kapcsolatban — számolt be az Associated Press.

Jelenleg rengeteg valósághű képi anyag, illetve beszámoló érkezik a blokád alá vont övezetből, de ezek gyakran hamis állításokkal és torzított igazságokkal keverednek. A háború korai szakaszában a MI-generált képek, köztük egy tűzszerűen elterjedt fotó egy síró babáról, amely a bombázás romjai között készült, terjedtek a közösségi médiában, míg más konfliktuszónákból származó fényképeket és videókat adtak ki friss bizonyítékként arról, ami Gázában történik.

Idővel az MI folyamatosan fejlődik, éppúgy ahogy a Photoshop programok tették. Szinte bárki képes meggyőző, hamis bizonyítékot létrehozni, ha szöveget ad meg az elérhető MI-generátoroknak, mint a DALL-E vagy a Midjourney a képek, videók vagy hangok elkészítéséhez.

A Leetaru-hoz hasonló személyiségek szerint pusztán az a tény, hogy léteznek deepfake-ek, zűrzavart okozhat, vagy arra késztetheti az embereket, hogy kétségbe vonják a valós híreket, valamint képi anyagokat. „Most hirtelen elárasztják a környezetet ismert hamis információkkal, így azt mondhatják, hogy “Ez a képi anyag háborús bűncselekményekről szól, de ez csak hamis hír, mint a többi.”

Egyszerűbben fogalmazva: a meggyőző hamis bizonyítékok létrehozásának képessége aggasztó, ráadásul lehetővé teszi, hogy az emberek elutasítsák a valós bizonyítékokat, aláásva a rögzített képek és videók megbízhatóságát, mint a valóság objektív ábrázolásait.

A német Kühne Logistics University elnöke és ügyvezető igazgatója, illetve a digitális átalakulás professzora Andreas Kaplan, úgy véli, kétségtelen, hogy az MI által generált tartalmak, köztük a deepfake videók és hasonló technológiák jelentős szerepet játszanak a narratívák formálásában, a közvélemény befolyásolásában és egyes perspektívák felerősítésében.

Azonban hatásuk a hamis információk terjedésére szerinte kevésbé jelentős.

„Más szóval, a generatív MI elsősorban az információs dezinformációk és félrevezető információk ellátásának egyszerűsítésében játszik szerepet, nem pedig az igényük vagy azok későbbi terjesztése terén” – mondta el Kaplan a TRT Worldnek, hozzátette, a valódi probléma akkor merül fel, amikor az emberek az MI eszközeit használják információszerzésre, ami „nem sokban különbözik attól, mint amikor az ember elfogadja a Wikipédia információit tényként, vagy elhiszi a politikai kampány során kapott automatikus hívásokat.”

Bár elismeri, hogy a szabályozó testületek gyakran lemaradnak az aktuális állapotról, Kaplan kihangsúlyozta, még mindig történnek erőfeszítések az MI által generált médiatartalmak, például deepfake-ek visszaélésének kezelésére. „Figyelembe kell venni az Európai Unió Bizottságának mesterséges intelligenciáról szóló javasolt szabályozását, amely előírja minden deepfake technológiával készült tartalom címkézését.”

Kaplan arra utalt, hogy ez az AI-törvény, amelyről 2023. december 9-én ideiglenes megállapodás született. Az áprilisi javaslatot 2021-ben terjesztették fel, és a végső szöveget még a Parlamentnek és a Tanácsnak formálisan el kell fogadnia ahhoz, hogy uniós joggá váljon. Ha jóváhagyják akkor az a világ első MI törvényi iránymutatása lesz.

„Hasonlóképpen, az Egyesült Államok is nemrégiben fokozta az erőfeszítéseit a deepfake-ek elleni küzdelemben, ami valószínűleg a novemberi elnökválasztás közeledtével vált sürgetővé.”

Kanada is egy törvénytervezetet tanulmányoz, amely szabályozná az egyes MI rendszereket. Az Egyesült Királyságban pedig az Online Safety Bill, — amelyet 2023 októberében fogadtak el — célja, hogy az ország „a legbiztonságosabb hely legyen a világon az online térben” új törvényekkel, amelyek zéró toleranciát tanúsítanak a gyermekek online megrontása ellen.

Az átlagos közösségi média felhasználó számára Kaplan szerint a megbízhatóság megítélése azt jelenti, hogy óvatosan kell bánni azzal az anyaggal, amit fogyasztanak, és kritikusan értékelniük kell, nem pedig elfogadniuk azt, amit első ránézésre bemutatnak.

„Fontos felismerni a saját elfogultságainkat, mivel hajlamosak vagyunk elhinni azokat az információkat, amelyek összhangban állnak az előítéleteinkkel” — mutatott rá Kaplan. „Ennek az elfogultságnak a felismerése segíthet az információk objektívebb elemzésében” — tette hozzá a professzor, akinek a kutatási területei közé tartozik a MI, a digitalizáció és a közösségi hálózatok fejlődése.

Összefoglalva: minél szenzációsabbnak tűnik a hír, annál fontosabb, hogy megvizsgáljuk annak forrását.