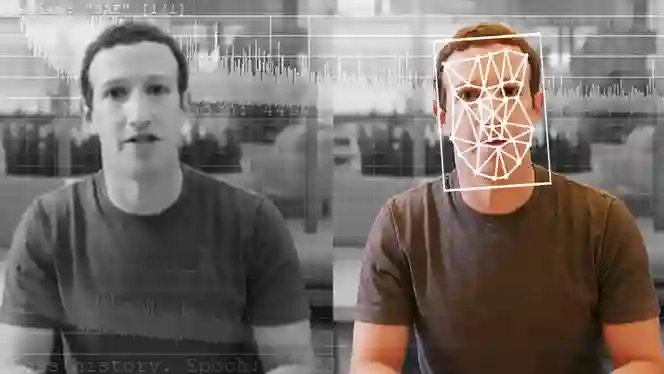

De la Hollywood și Washington până la cronologia rețelelor sociale și World Wide Web, deepfake-urile – o combinație de „învățare profundă” și „fals” – și alte medii sintetice realizate cu inteligență artificială (IA) au proliferat mai repede decât și-ar fi putut imagina oricare dintre noi.

Numai în 2023, s-au descoperit că cel puțin 95.820 de videoclipuri deepfake s-au infiltrat pe internet.

Sigur, poate fi distractiv să-l urmărești pe Kendrick Lamar transformându-se în Kanye, Will Smith și Nipsey în single-ul din 2022 al rapperului câștigător al premiului Pulitzer, The Heart Part 5. S-ar putea chiar să simți un sentiment de catharsis când privești un clip redat unde Jon Snow își cere scuze pentru ultimul sezon din Game of Thrones dacă sunteți printre cei (încă) nemulțumiți de modul în care serialul iconic în cele din urmă s-a încheiat.

Dar ce se întâmplă atunci când aceste cazuri de manipulare IA sunt aplicate în scopuri mai nefaste? Datele și sondajele indică faptul că majoritatea oamenilor nu pot detecta în mod fiabil deepfake-urile, unii recunoscând că au vizionat videoclipuri pe care le-au crezut inițial că sunt reale, pentru a afla mai târziu că sunt false.

În cea mai mare parte, atenția asupra pericolelor pe care le prezintă deepfake-urile cade de obicei pe dezinformarea de tip politic. Această tehnologie, totuși, a fost folosită în mod constant pentru a hărțui și a abuza femei, inclusiv persoane precum Taylor Swift, ale cărei privilegii și statutul de vedetă pop nu au exclus-o de a fi victimă a materialelor pornografice nonconsensuale.

„Din păcate, nu ar trebui să fim atât de surprinși că deepfake-urile sunt folosite pentru a denigra femeile”, a declarat Sophie Toupin, profesor asistent la Departamentul de Informare și Comunicare al Universității Laval, pentru TRT World.

După ce falsurile sexuale explicite ale cântăreței Anti-Hero au devenit virale pe platformele de socializare la sfârșitul lunii ianuarie, baza de fani înflăcărată a lui Swift, cunoscută sub numele de Swifties, a intrat în acțiune. Fanii au umplut rapid X cu imagini pozitive cu Swift și au raportat conturi care împărtășeau deepfake-urile, făcând ca hashtag-ul #ProtectTaylorSwift să devină trend.

Modul în care Swifties au ripostat deține o importanță socială și culturală imensă, spune Toupin, deoarece ajută la stabilirea normelor privind utilizarea acceptabilă și inacceptabilă a mediilor sintetice generate de inteligență artificială, indiferent dacă ești una dintre cele mai mari vedete pop din lume sau nu.

„Deși acest răspuns rapid a avut un succes imens, este important să recunoaștem că nu toată lumea are acces la un sprijin atât de solid al comunității”, spune Toupin. „Comunitatea de fani a lui Taylor Swift a servit ca un exemplu notabil de răspuns feminist care a afirmat ferm: „Acest lucru nu este acceptabil”.

„Sper că toate femeile și fetele care sunt supuse unei astfel de practici denigratoare vor primi același răspuns rapid. De fapt, la nivel de comunitate, acest tip de solidaritate este exact ceea ce este necesar pentru a spune nu conținutului misogin și rasist fals generat de inteligență artificială online”, adaugă Toupin.

În termeni simpliști, deepfake-urile sunt o formă de media sintetică care folosește inteligența artificială pentru a schimba asemănarea și aspectul feței unei persoane cu cea a altei în videoclipuri.

Inițial, a fost propulsat de un utilizator Reddit, numit Deepfakes, care în 2017 a început să posteze conținut pentru adulți nonconsensual și modificat digital, care prezenta fețe de celebrități suprapuse pe corpurile femeilor din filmele pentru adulți.

Vorbind cu Vice Motherboard, utilizatorul a spus că a folosit mai multe biblioteci open-source pentru a crea videoclipuri, inclusiv TensorFlow de la Google, care este gratuit de utilizat.

„Pe partea tehnică, este esențial să ținem cont de faptul că ușurința cu care mulți oameni pot crea deepfake-uri generate de IA depinde de software-ul disponibil generat de IA”, explică Toupin. „Aceste software au fost instruite pe cantități mari de conținut generate și partajate de noi, utilizatorii de internet, în ultimele două decenii. Aceasta este o problemă importantă de avut în vedere.”

În urma a ceea ce s-a întâmplat cu Swift, parlamentarii și cetățenii obișnuiți au cerut protecție mai puternică împotriva imaginilor create de IA, care, din Australia până în Spania și peste tot în lume, s-au răspândit într-un ritm alarmant și din ce în ce mai rapid, în timp ce dăunează în mod covârșitor femeilor și copiilor.

Recent, deputatul victorian Georgie Purcell a reclamat mass-media locală pentru că și-a modificat corpul pentru a-și face bustul să pară mai mare și i-a îndepărtat parțial părți din îmbrăcăminte, numind-o un exemplu al tratamentului „continuu, insidios” al femeilor în politică în mass-media.

Potrivit unui raport din 2023, pornografia deepfake reprezintă 98% din toate videoclipurile deepfake online, iar 99% dintre persoanele vizate de pornografia deepfake sunt femei, subliniind necesitatea unui cadru de reglementare mai bun.

„Să ne amintim că, dacă consumăm medii sintetice care au fost făcute fără acordul persoanei înfățișate, faci parte și tu din problemă”, spune Toupin. „Este important să înțelegeți că vă face plăcere violența digitală bazată pe gen.”

Oricât de revoluționară este, epoca deepfake-urilor se dovedește a crea noi provocări și temeri pentru legislatorii și guvernele care s-au luptat să reglementeze în mod corespunzător această tehnologie care deține capacitatea de a face pe oricine să pară să spună și să facă orice la un moment dat.

Disponibilitatea din ce în ce mai mare a dezinformarii și a deepfake-urilor, se arată într-un raport din 2022 al Agenției Uniunii Europene pentru Cooperare în Aplicarea Legii, „va avea un impact profund asupra modului în care oamenii percep autoritatea și mass-media de informare”, pe lângă subcotarea încrederii în autorități și în faptele oficiale.

„Experții se tem că acest lucru poate duce la o situație în care cetățenii nu mai au o realitate comună sau ar putea crea confuzie în societate cu privire la sursele de informații fiabile, o situație denumită uneori „apocalipsă informațională” sau „apatie a realității”, potrivit raportului Europol.

Multă vreme, oamenii au apelat la fotografii și videoclipuri pentru a completa orice informație citită înainte de a accepta pe deplin ceva ca fapt, în esență, ținând seama de sfatul „Nu-l crede până nu îl vezi”.

Având în vedere alegerile prezidențiale programate pentru noiembrie, cele mai recente date spun că americanii sunt „foarte îngrijorați” de utilizarea inteligenței artificiale și de falsurile profunde ale candidaților și personalităților politice, cu o majoritate puternică a alegătorilor din toate liniile de partid considerând că tehnologia ar trebui reglementată în mod corespunzător.

Îngrijorarea lor nu este neîntemeiată. Chiar luna trecută, în ianuarie, un apel automat fals care pare a fi o voce IA a președintelui Joe Biden i-a îndemnat pe locuitorii din New Hampshire să nu voteze la alegerile primare democrate din stat.

Și în septembrie 2023, guvernatorul Floridei, Ron DeSantis, a fost vizat într-un deepfake viral în care anunța că renunță la cursa prezidențială din 2024, după ce a fost lansat un videoclip manipulat de inteligență artificială cu fostul președinte Donald Trump și Anthony Fauci îmbrățișându-se cu câteva luni mai devreme.

„Instrumentele și sistemele necesare pentru a produce materialele sunt ușor disponibile”, a declarat pentru Forbes analistul industriei tehnologice Charles King de Pund-IT. „La fel de important, climatul politic actual din SUA este atât de fracturat și urât încât există mari audiențe de oameni de ambele părți gata să creadă ce e mai rău despre ceilalți.”

În jurnalism și în activitatea de investigație, înregistrările audio și vizuale, alături de fotografii și text, nu numai că sunt adesea considerate dovezi de încredere, dar ajută și jurnaliştii și anchetatorii să determine ce este real și ce nu este.

Au existat și alte forme de manipulare digitală, cum ar fi Photoshop, dar de obicei ai avea nevoie de un anumit nivel de expertiză pentru a ascunde urmele de editare. În plus, rezultatele nu au fost în general la fel de sofisticate precum cele oferite de tehnologia IA.

Cu inteligența artificială în imagine, perspectiva pentru informații false crește exponențial, cu atât mai mult în perioadele de conflict și război, spune Dr. Kalev Hannes Leetaru, fondatorul Proiectului GDELT, o bază de date în timp real cu evenimente globale, limbaj și ton.

„Există foarte mult potențial acum ca actorii răi – fie că este vorba de Gaza, fie că este vorba de Ucraina sau de orice alt conflict – să folosească aceste instrumente pentru a crea falsități hiperpersonalizate la scară”, declară pentru TRT World Leetaru a cărui activitate se bazează pe valorificarea tehnologiilor avansate și înțelegerea modului în care acestea remodelează societatea globală.

„Imaginați-vă o [platformă] de socializare sau un actor prost ar putea privi întreaga populație a țării și apoi să vizeze fiecare persoană de acolo și să le ofere ceva ce știe, pe baza istoriei lor, că îi va provoca și distruge cu adevărat societățile”, explică el, adăugând: „Sau dimpotrivă, atunci când documentația legitimă a crimelor de război iese dintr-o zonă de conflict”.

În 2022, un videoclip fals l-a arătat pe președintele ucrainean Volodimir Zelenski spunând soldaților săi să depună armele împotriva Rusiei, dar mulți au identificat corect semne de manipulare digitală, inclusiv modul în care fața lui părea ușor nesincronizată cu capul și un accent nepotrivit.

Anul următor, în iunie, mai multe mass-media ruse s-au îndrăgostit de un videoclip similar fals, dar mai convingător cu președintele rus Vladimir Putin. Și în decembrie, un deepfake IA despre el l-a surprins pe președintele rus în timp ce acesta se afla la o conferință de presă anuală.

Războiul Israelului împotriva Gaza, care a ucis peste 27.800 de palestinieni și a rănit alți peste 67.000 de când au început atacurile militare din 7 octombrie, a crescut, de asemenea, temerile cu privire la puterea IA de a induce în eroare, relatează Associated Press.

În acest moment, există o mulțime de imagini reale și relatări despre măcel care ies la suprafață din enclava asediată, dar ele pot apărea alături de un amestec de afirmații false și adevăruri distorsionate. La începutul războiului, imagini generate de inteligență artificială, inclusiv o imagine virală a unui copil plângând în mijlocul ruinelor unui bombardament, au plutit pe rețelele de socializare, în timp ce fotografiile și videoclipurile din alte zone de conflict au fost prezentate ca dovadă recentă a ceea ce se întâmplă în Gaza.

De-a lungul timpului, IA a continuat să se îmbunătățească și va continua să o facă, așa cum au făcut-o animația pe computer sau software-ul de editare, cum ar fi Photoshop. Aproape oricine poate crea un fals persuasiv introducând text în generatoare de IA ușor disponibile, cum ar fi DALL-E sau Midjourney, pentru a produce imagini, video sau audio.

Experți, precum Leetaru, spun că simplul fapt că există deepfake-uri poate deruta sau îi poate determina pe oameni să pună la îndoială știrile reale sau imaginile autentice. „Acum inundați brusc mediul cu informații false cunoscute, așa că puteți spune: „Ei bine, imaginile acelea care sunt crime de război, sunt doar știri false ca și celelalte chestii.”

Mai simplu spus, abilitatea de a crea dovezi false convingătoare este îngrijorătoare și, mai mult, le permite oamenilor să respingă dovezi reale, subminând încrederea în imaginile și videoclipurile înregistrate ca reprezentări obiective ale realității.

Președintele și directorul general al Universității de Logistică Kühne din Germania, Andreas Kaplan, care este și profesor de transformare digitală, observă că nu există nicio îndoială că conținutul generat de IA, inclusiv videoclipurile deepfake și tehnologii similare, joacă un rol semnificativ în modelarea narațiunilor, influențând opinia publică, și amplificarea perspectivelor specifice.

Cu toate acestea, impactul său asupra răspândirii informațiilor false, spune el, este mult mai puțin puternic.

„Pentru a spune altfel, IA generativă simplifică în primul rând furnizarea de dezinformare mai degrabă decât cererea pentru aceasta sau diseminarea ulterioară a acesteia”, spune Kaplan pentru TRT World, adăugând că adevărata problemă apare atunci când oamenii se bazează pe instrumentele IA pentru informații care „nu este foarte diferit de acceptarea informațiilor de pe Wikipedia ca fapte sau de a crede în apelurile roboților primite în timpul unei campanii politice”.

Deși recunoaște că organismele de reglementare sunt adesea în urmă față de situația actuală, Kaplan subliniază că încă se fac eforturi pentru a aborda abuzul și utilizarea greșită a conținutului media generat de IA, inclusiv deepfake-urile. „De remarcat este proiectul de regulamentare al Comisiei Uniunii Europene privind inteligența artificială, care impune etichetarea întregului conținut creat folosind tehnologia deepfake.”

La ce se referă Kaplan este Actul IA, pentru care s-a ajuns la un acord provizoriu la 9 decembrie 2023. Propus pentru prima dată în aprilie 2021, textul convenit va trebui să fie adoptat oficial de Parlament și Consiliu pentru a deveni lege UE. Odată aprobat, actul va oferi linii directoare pentru primele reguli din lume privind IA.

„În mod similar, Statele Unite și-au intensificat recent eforturile de a introduce o legislație care vizează combaterea deepfake-urilor, o mișcare probabil stimulată de apropierea alegerilor prezidențiale din noiembrie”.

Canada studiază, de asemenea, un proiect de lege care ar începe să reglementeze unele sisteme IA. Și în Marea Britanie, Legea privind siguranța online, care a fost adoptată în octombrie 2023, își propune să facă din țară „cel mai sigur loc din lume pentru a fi online” prin noi legi care adoptă o abordare de toleranță zero pentru a proteja copiii de daunele online.

Pentru utilizatorul obișnuit al rețelelor sociale, potrivit lui Kaplan, a determina dacă ceva este demn de încredere înseamnă să fii precaut cu materialul pe care îl consumi și să-l evaluezi critic, mai degrabă decât să accepti ceea ce este prezentat la valoarea nominală.

„Este, de asemenea, important să recunoaștem propriile părtiniri, deoarece adesea avem tendința de a crede informații care se aliniază cu preconcepțiile noastre”, spune Kaplan. „Conștientizarea acestei părtiniri poate ajuta la o analiză mai obiectivă a informațiilor”, adaugă profesorul al cărui domeniu de cercetare include progrese în IA, digitalizare și rețele sociale.

„Pentru a rezuma, cu cât știrile par mai senzaționale, cu atât devine mai critică examinarea sursei sale.”