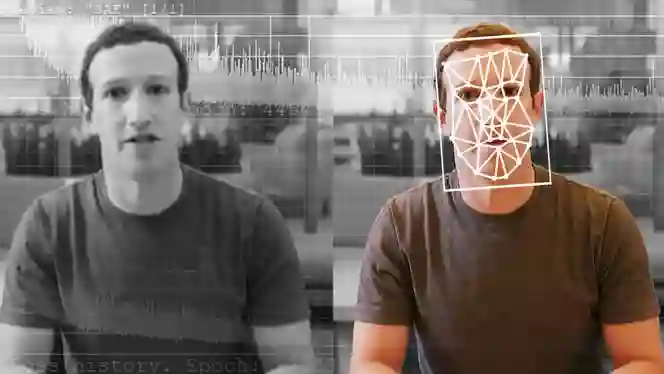

De Hollywood e Washington às linhas do tempo das redes sociais e à World Wide Web, deepfakes — uma combinação de "deep learning" (aprendizagem profunda) e "fake" (falso) — e outros conteúdos multimédia sintéticos criados com inteligência artificial (IA) têm-se proliferado mais rapidamente do que qualquer um de nós poderia imaginar.

Apenas em 2023, pelo menos 95.820 vídeos deepfake foram encontrados infiltrados na Internet.

Claro, pode ser engraçado e divertido ver Kendrick Lamar transformar-se em Kanye, Will Smith e Nipsey no single “The Heart Part 5” do rapper premiado com o Pulitzer em 2022. Pode até sentir uma sensação de catarse ao reproduzir um clipe renderizado de Jon Snow a pedir desculpas pelo enredo da temporada final de “The Game of Thrones”, se estiver entre aqueles (ainda) insatisfeitos com o fim da série icónica.

Mas o que acontece quando estes casos de manipulação por IA são aplicados para propósitos mais nefastos? Dados e investigações indicam que a maioria das pessoas não consegue detetar deepfakes de forma fiável, com alguns a admitirem terem visto vídeos que inicialmente pensavam ser reais, apenas para descobrir depois que eram falsos.

Em grande parte, o foco sobre os perigos que os deepfakes representam geralmente recai sobre a desinformação de natureza política. Esta tecnologia, no entanto, tem sido consistentemente utilizada para assediar e abusar de mulheres, incluindo personalidades como Taylor Swift, cujo privilégio e estatuto de estrela pop não a excluíram de ser vítima de material pornográfico não consensual.

"Infelizmente, não nos devemos surpreender que deepfakes sejam utilizados para degradar mulheres", diz Sophie Toupin, Professora assistente do Departamento de Informação e Comunicação da Université Laval, à TRT World.

Depois de deepfakes sexualmente explícitos da cantora de “Anti-Hero” se tornarem virais nas plataformas das redes sociais no final de janeiro, a base de fãs fervorosos de Swift, conhecida como Swifties, entrou em ação. Os fãs rapidamente inundaram o X com imagens positivas de Swift e denunciaram contas que estavam a partilhar os deepfakes, fazendo a hashtag #ProtectTaylorSwift tornar-se viral.

A forma como os Swifties reagiram tem imensa importância social e cultural, diz Toupin, pois ajuda a estabelecer normas sobre o uso aceitável e não aceitável de conteúdo multimédia sintético gerado por IA — seja para uma das maiores estrelas pop do mundo ou não.

"Embora esta resposta rápida tenha sido imensamente bem-sucedida, é importante reconhecer que nem todos têm acesso a um suporte comunitário tão robusto", diz Toupin. "A comunidade de fãs de Taylor Swift serviu como um exemplo notável de uma resposta feminista que afirmou firmemente: 'Isto não é aceitável'".

"Espero que todas as mulheres e meninas que estão sujeitas a esta prática degradante recebam a mesma resposta rápida. De facto, ao nível comunitário, este tipo de solidariedade é exatamente o que é necessário para dizer não ao conteúdo misógino e racista falso gerado por IA online", acrescenta Toupin.

Em termos simplistas, deepfakes são uma forma de conteúdo multimédia sintético que utiliza IA para trocar a aparência e características faciais de uma pessoa com as de outra em vídeos.

Foi inicialmente impulsionado por um utilizador do Reddit que usava a alcunha Deepfakes, que em 2017 começou a publicar conteúdo adulto não consensual e digitalmente alterado que apresentava rostos de celebridades sobrepostos aos corpos de mulheres em filmes adultos.

Falando ao “Motherboard” da Vice, o utilizador disse que empregou várias bibliotecas de código aberto para criar os vídeos, incluindo o TensorFlow da Google, que é gratuito.

"No aspeto técnico, é crucial ter em mente que a facilidade com que muitas pessoas podem criar deepfakes gerados por IA depende do software de IA disponível", explica Toupin. "Estes softwares foram treinados em vastas quantidades de conteúdo gerado e partilhado por nós, utilizadores da Internet, nas últimas duas décadas. Esta é uma questão importante a ser considerada."

Após o que aconteceu com Swift, legisladores e cidadãos comuns exigiram proteções mais fortes contra imagens criadas por IA, que, da Austrália à Espanha, têm-se proliferado a um ritmo alarmante e crescente, ao mesmo tempo que prejudicam de forma esmagadora mulheres e crianças.

Recentemente, a deputada Georgie Purcell denunciou um órgão de comunicação local por alterar o seu corpo para fazer o seu busto parecer maior e remover parcialmente partes da sua roupa, alegando que este é um exemplo do tratamento "contínuo e insidioso" das mulheres na política pelos media.

De acordo com um relatório de 2023, a pornografia deepfake representa 98% de todos os vídeos deepfake online, e 99% dos indivíduos vítimas de pornografia deepfake são mulheres, enfatizando a necessidade de uma estrutura regulatória melhor.

"Vamos lembrar que se consumirmos vídeos artificiais que foram feitos sem o consentimento da pessoa retratada, também fazemos parte do problema", diz Toupin. "É importante que entendemos que estamos a ter prazer com violência digital baseada no género".

Por mais revolucionária que seja, a era dos deepfakes está a provar criar novos desafios e medos aos legisladores e governos que se têm esforçado para regular adequadamente esta tecnologia que tem a capacidade de fazer qualquer pessoa parecer dizer e fazer qualquer coisa a qualquer momento.

A crescente disponibilidade de desinformação e deepfakes, afirma um relatório de 2022 da Agência da União Europeia para Cooperação Policial, "terá um profundo impacto na maneira como as pessoas percebem a autoridade e os media de informação", além de minar a confiança nas autoridades e factos oficiais.

"Especialistas temem que isso possa levar a uma situação onde os cidadãos deixam de ter uma realidade partilhada, ou poderá criar confusão social sobre quais fontes de informação são confiáveis; uma situação às vezes referida como 'apocalipse da informação' ou 'apatia da realidade'", de acordo com o relatório da Europol.

Durante muito tempo, as pessoas recorreram a fotos e vídeos para complementar qualquer peça de informação que leram antes de aceitar completamente algo como um facto; essencialmente, seguindo o conselho de “Não acredite até ver”.

Com a eleição presidencial marcada para novembro, os dados mais recentes dizem que os americanos estão "altamente preocupados" com o uso de IA e deepfakes de candidatos e figuras políticas, com uma forte maioria de eleitores de todos os partidos que acreditam que a tecnologia deve ser devidamente regulamentada.

Esta preocupação não é infundada. Apenas no mês passado, uma chamada automática falsa que parecia ser uma voz de IA do Presidente Joe Biden instou os residentes de New Hampshire a não votarem nas eleições primárias democratas do estado.

E em setembro de 2023, o governador da Flórida Ron DeSantis foi alvo de um deepfake viral que anunciou que ele desistiu da corrida presidencial de 2024, depois de ter lançado um vídeo manipulado por IA do ex-presidente Trump e Anthony Fauci a abraçarem-se alguns meses antes.

"As ferramentas e sistemas necessários para produzir este material estão facilmente disponíveis", disse o analista da indústria de tecnologia Charles King da Pund-IT à Forbes. "Igualmente importante, o clima político atual nos EUA está tão fraturado e feio que há grandes e prontas audiências de pessoas de ambos os lados prontas para acreditar no pior sobre os outros".

No jornalismo e trabalho investigativo, gravações de áudio e vídeo, junto com fotografias e texto, não são apenas frequentemente consideradas evidências confiáveis, mas também ajudam jornalistas e investigadores a determinar o que é real e o que não é.

Outras formas de manipulação digital, como o Photoshop, existiam, mas geralmente você precisava de um certo nível de experiência para esconder traços de edição. Além disso, os resultados geralmente não eram tão sofisticados quanto os renderizados pela tecnologia de IA.

Com a IA em cena, a perspectiva de informações falsas cresce exponencialmente, ainda mais em tempos de conflito e guerra, diz o Dr. Kalev Hannes Leetaru, fundador do Projeto GDELT, um banco de dados em tempo real de eventos globais, linguagem e tom.

"Há muito potencial agora para atores maliciosos — seja [sobre] Gaza, seja [sobre] a Ucrânia ou qualquer outro conflito — usarem essas ferramentas para criar falsidades hiperpersonalizadas em escala", diz Leetaru, cujo trabalho gira em torno do aproveitamento de tecnologias avançadas e compreensão da forma como elas remodelam a sociedade global, à TRT World.

"Imagine que uma plataforma de redes sociais ou um agente mal-intencionado poderia analisar toda a população de um país inteiro, e depois direcionar cada pessoa e fornecer-lhes algo que sabem, com base no seu histórico, que os vai enfurecer tanto ao ponto de realmente dividir as sociedades", explica ele, acrescentando: "Ou, inversamente, quando surgem documentações legítimas de crimes de guerra vindas de uma zona de conflito."

Em 2022, um vídeo falso mostrou o Presidente ucraniano Volodymyr Zelenskyy a dizer aos seus soldados para baixarem as armas contra a Rússia, mas muitos discerniram corretamente sinais de manipulação digital, incluindo como o seu rosto parecia ligeiramente fora de sincronia com a sua cabeça e um sotaque que soava estranho.

No ano seguinte, em junho, várias media russos caíram nm vídeo falso semelhante, mas mais convincente, do Presidente russo Vladimir Putin. E em dezembro, um deepfake de IA dele surpreendeu o presidente russo durante uma conferência de imprensa anual.

A guerra de Israel em Gaza, que matou mais de 27.800 palestinianos e feriu mais de 67.000 desde que os ataques militares começaram em 7 de outubro, também aumentou os temores sobre o poder da IA de enganar, relata a Associated Press.

Agora mesmo, há muitas imagens reais e relatos de carnificina a surgir do enclave sitiado, mas eles podem aparecer ao lado de uma mistura de alegações falsas e verdades distorcidas. No início da guerra, imagens geradas por IA, incluindo uma imagem viral de um bebé a chorar nas ruínas de um bombardeio, circularam nas redes sociais, enquanto fotos e vídeos de outras zonas de conflito foram passadas como prova recente do que está acontecendo em Gaza.

Com o tempo, a IA apenas continuou a melhorar, e continuará a fazê-lo assim como a animação computadorizada ou software de edição como o Photoshop fizeram. Quase qualquer pessoa pode criar uma falsificação persuasiva inserindo texto em geradores de IA prontamente disponíveis como o DALL-E ou o Midjourney para produzir imagens, vídeo ou áudio.

Especialistas, como Leetaru, dizem que o mero facto de existirem deepfakes pode confundir ou levar as pessoas a duvidar de notícias reais ou imagens autênticas. "Agora podes estar de repente a inundar o ambiente com informações sabidamente falsas, e podes dizer: 'Bem, aquela imagem que é de crimes de guerra, isso é apenas uma notícia falsa tal como isto".

Em termos simples, a capacidade de criar evidências falsas convincentes é preocupante, e além disso, também permite que as pessoas descartem evidências reais, minando a confiança em imagens e vídeos gravados como representações objetivas da realidade.

O Presidente e Diretor da Universidade de Logística Kühne da Alemanha, Andreas Kaplan, que também é professor de transformação digital, observa que há pouca dúvida de que o conteúdo gerado por IA, incluindo vídeos deepfake e tecnologias similares, desempenham um papel significativo na formação de narrativas, influenciando a opinião pública e amplificando perspectivas específicas.

No entanto, o seu impacto na disseminação de informações falsas, diz ele, é muito menos poderoso.

“Por outras palavras, a IA generativa simplifica principalmente o fornecimento de informações erradas e desinformação, em vez da procura por ela ou a sua subsequente disseminação", diz Kaplan à TRT World, acrescentando que a questão real surge quando as pessoas confiam em ferramentas de IA para informação, o que "não é muito diferente de aceitar informação na Wikipedia como um facto ou acreditar em ligações automáticas recebidas durante uma campanha política."

Embora ele reconheça que os órgãos reguladores frequentemente ficam atrás do estado atual das coisas, Kaplan destaca que ainda há esforços a fazer para abordar o abuso e mau uso do conteúdo de media gerado por IA, incluindo deepfakes. "Notável é o projeto de regulamento da Comissão da União Europeia sobre inteligência artificial, que exige a rotulagem de todo o conteúdo criado usando tecnologia deepfake."

O que Kaplan se refere é o “AI Act”, para o qual foi alcançado um acordo provisório em 9 de dezembro de 2023. Primeiro proposto em abril de 2021, o texto acordado terá que ser formalmente adotado pelo Parlamento e Conselho para se tornar lei da União Europeia. Uma vez aprovado, o ato fornecerá diretrizes para as primeiras regras do mundo sobre IA.

"Da mesma forma, os Estados Unidos recentemente intensificaram os esforços para introduzir legislação destinada a combater deepfakes, um movimento provavelmente estimulado pela aproximação da eleição presidencial neste novembro."

O Canadá também está a estudar um projeto de lei que começará a regular alguns sistemas de IA. E no Reino Unido, o “Online Safety Bill”, que foi aprovado em outubro de 2023, visa tornar o país "o lugar mais seguro do mundo para estar online" através de novas leis que adotam uma abordagem de tolerância zero para proteger crianças de serem atacadas online.

Para o utilizador médio das redes sociais, de acordo com Kaplan, determinar se algo é confiável significa ser cauteloso com o material que consomes, e avaliá-lo criticamente em vez de aceitar o que é apresentado como verdade absoluta.

"Também é importante reconhecer os seus próprios preconceitos, já que frequentemente temos uma tendência a acreditar em informações que se alinham com as nossas concepções", diz Kaplan. "Estar ciente desse preconceito pode ajudar numa análise mais objetiva da informação", acrescenta o professor, cuja área de pesquisa inclui avanços em IA, digitalização e redes sociais.

"Em resumo, quanto mais sensacional a notícia parece, mais crítico se torna examinar a sua fonte".